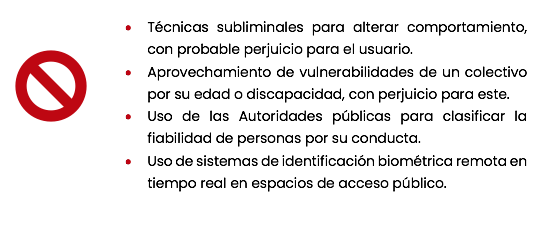

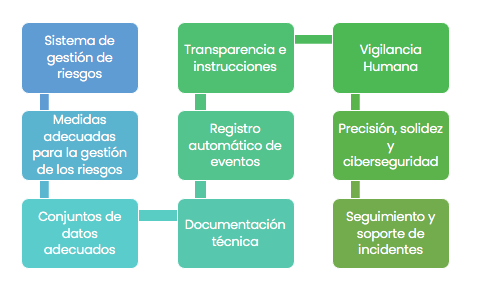

En el anterior post del pasado 22 de marzo hablábamos sobre esta nueva ley de inteligencia artificial en lo que a aplicaciones prohibidas, exenciones de las fuerzas de seguridad y obligaciones para los sistemas de de alto riesgo se refiere. Hoy os contamos el resto sobre esta nueva regulación de inteligencia artificial.

Regulación y requisitos de transparencia

Los sistemas de IA de uso general y los modelos en los que se basan deben cumplir ciertos requisitos de transparencia, respetar la legislación de la UE sobre derechos de autor y publicar resúmenes detallados del contenido usado para entrenar sus modelos. Los modelos más potentes que podrían plantear riesgos sistémicos deberán cumplir requisitos adicionales, como realizar evaluaciones de los modelos, analizar y mitigar los riesgos sistémicos e informar sobre los incidentes.

Además, las imágenes, contenidos de audio o de vídeo artificiales o manipulados («ultrafalsificaciones») deberán etiquetarse claramente como tales, según indica la regulación.

Medidas de apoyo a la innovación y a las pymes

Habrá que poner a disposición de las pymes y de las empresas emergentes espacios controlados de pruebas y ensayos en condiciones reales a nivel nacional para que puedan desarrollar y entrenar la IA innovadora antes de su comercialización.

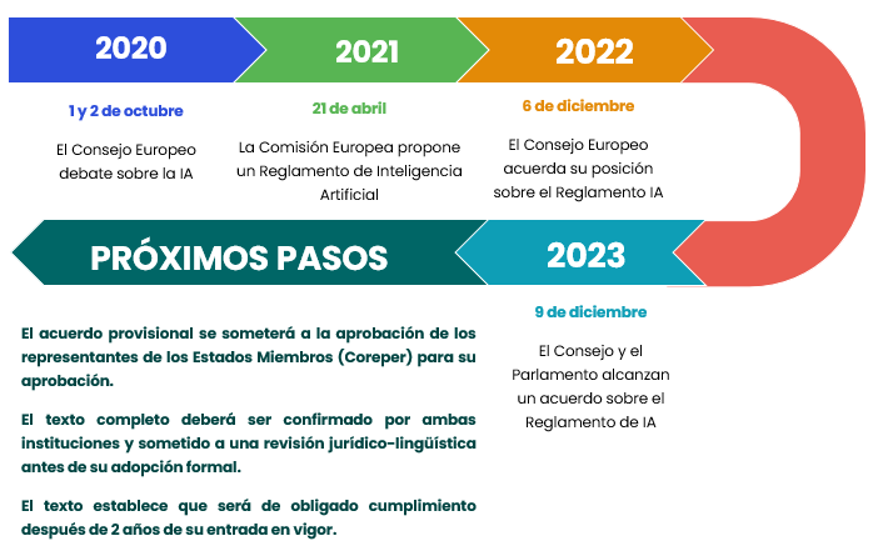

Próximos pasos

El Reglamento aún está sujeto a una última comprobación jurídica-lingüística. Su aprobación definitiva (mediante el llamado procedimiento de corrección de errores) está prevista para antes del final de la legislatura. La ley también debe ser adoptada formalmente por el Consejo.

Entrará en vigor veinte días después de su publicación en el Diario Oficial y será de plena aplicación veinticuatro meses después de su entrada en vigor, con excepción de: las prohibiciones de prácticas (se aplicarán seis meses después de la fecha de entrada en vigor); los códigos de buenas prácticas (nueve meses después); las normas sobre la IA de uso general, incluida la gobernanza (doce meses después), y las obligaciones para los sistemas de alto riesgo (treinta y seis meses después).

Conferencia sobre el Futuro de Europa

La Ley de Inteligencia Artificial responde directamente a las propuestas de los ciudadanos de la Conferencia sobre el Futuro de Europa, más concretamente a la propuesta 12(10), relativa a la mejora de la competitividad de la UE en sectores estratégicos, la propuesta 33(5), sobre una sociedad segura y fiable, incluida la lucha contra la desinformación y la garantía de que las personas tengan el control final, la propuesta 35 sobre la promoción de la innovación digital, (3) la garantía de la supervisión humana y (8) un uso fiable y responsable de la IA, el establecimiento de salvaguardias y la garantía de transparencia, y la propuesta 37(3), sobre el uso de la IA y las herramientas digitales para mejorar el acceso de los ciudadanos a la información, incluidas las personas con discapacidad.